Contenido del Articulo

Plan de lecciones:

Métodos de codificación

Código binario

Procesamiento de imágenes gráficas

Método de coordenadas

Conversión de números en código binario

Transformación del sonido

Procesamiento de texto

Ejemplos de codificación de la información:

- difusión de mensajes escritos utilizando letras rusas (ABVGD…EuYA);

- registrando los números en números (0123456789);

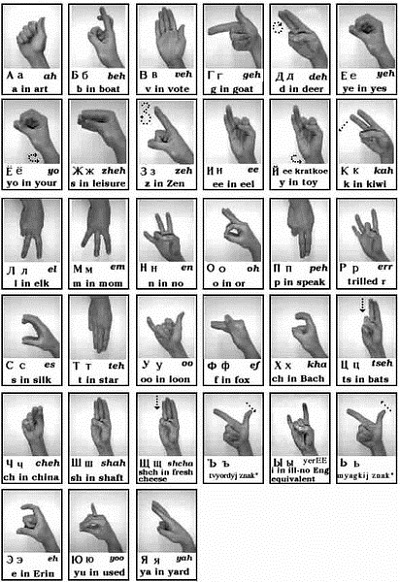

- el uso del lenguaje de signos

Fuente.

En otras palabras, la transición de un mensaje de una forma a otra, de acuerdo con ciertas reglas, y expresa lo que la esencia de la codificación de la información.

La información está codificada para fines:

- para simplificar la recopilación de datos en bruto;

- para reducir la cantidad de memoria ocupada por los mensajes de información;

- conveniencia de almacenamiento de material;

- procesamiento e intercambio de información eficiente;

- reteniendo la información necesaria.

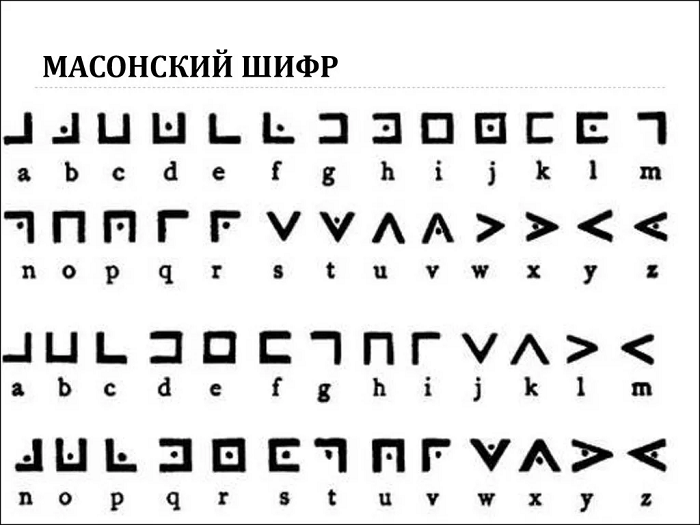

La historia de la codificación de la información se remonta a cientos de siglos. Hace mucho tiempo la gente usaba criptogramas (mensajes cifrados).

Fuente.

En el siglo XIX, con la invención del telégrafo por S. Morse, se inventó un método fundamentalmente nuevo de encriptación. El mensaje telegráfico se transmitía por cables mediante una secuencia de señales cortas y largas (punto y guión).

Fuente.

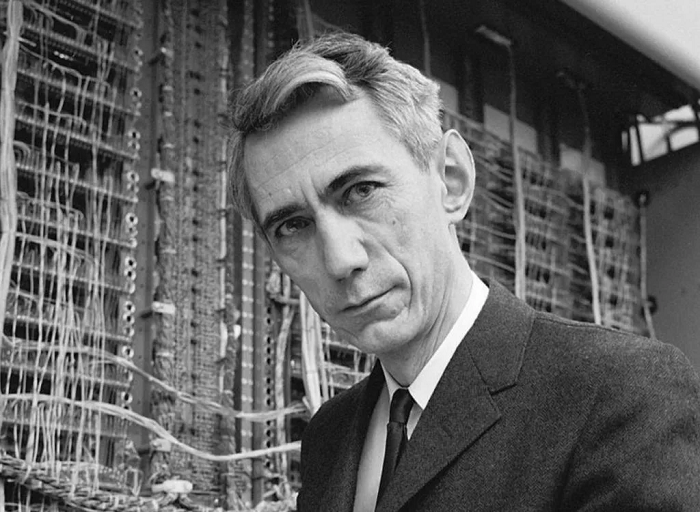

Después de él, J. Bodeau creó un método fundamental de codificación binaria de la información en la historia de la informática moderna, que consiste en aplicar sólo dos señales eléctricas diferentes. La codificación de la información en una computadora también implica el uso de dos números.

Desarrollado en 1948. La “Teoría de la Información y la Codificación” de C. Shannon se convirtió en fundamental en la codificación moderna de datos.

Fuente.

La codificación de la información en la informática, uno de los temas básicos. Comprender qué procedimiento de codificación de la información transmitida, cómo se lleva a cabo, ayudará en el estudio de los principios de funcionamiento del ordenador.

Métodos de codificación

Analicemos varios tipos de información y las peculiaridades de su codificación.

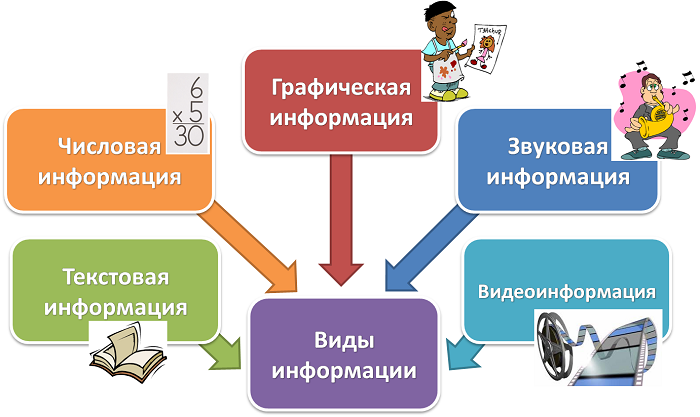

De acuerdo con el principio de presentación, toda la información puede clasificarse en los siguientes grupos:

- …gráfico;

- información de audio (sonido);

- de carácter (texto);

- numérico;

- información de video.

Fuente.

Los métodos de codificación de la información están condicionados por los objetivos fijados, así como por las posibilidades disponibles, los métodos de su procesamiento ulterior y su conservación. Los mensajes idénticos pueden presentarse en forma de imágenes y signos convencionales (método gráfico), números (método numérico) o símbolos (método de símbolos).

Métodos de codificación.

En consecuencia, la información también se clasifica por el método de codificación:

- Los mensajes simbólicos incluyen señales de tráfico, semáforos, etc;

- Los datos de texto son libros, notas, documentos varios;

- Todo tipo de imágenes (fotos, esquemas, dibujos) representan toda la variedad de información gráfica.

Para descifrar el mensaje que se muestra en el sistema de codificación de información seleccionado, es necesario realizar la descodificación, es decir, el proceso de recuperación del material original. Para desencriptar con éxito, hay que conocer el tipo de código y los métodos de cifrado.

Los tipos más comunes de codificación de la información son los siguientes:

- conversión de texto;

- codificación gráfica;

- codificación de datos numéricos;

- la conversión del sonido en una secuencia numérica binaria;

- codificación de video.

Se hace una distinción entre los métodos de codificación de la información como:

- Método de sustitución (substitución) – los caracteres del mensaje inicial se sustituyen por los caracteres correspondientes del algoritmo de código seleccionado;

- método de permutación – los caracteres del texto original se cambian en lugares según un cierto esquema;

- Método de juego – una secuencia aleatoria de otros caracteres se añade a las designaciones originales.

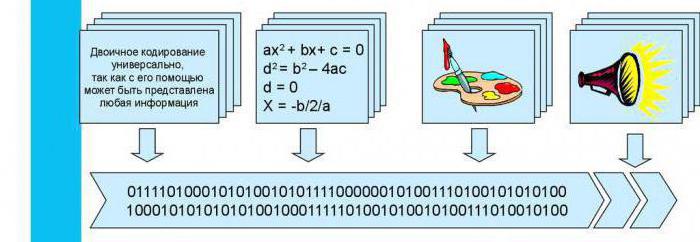

Código binario

El método de codificación de información más utilizado es la codificación binaria. La codificación de datos con código binario se utiliza en todas las tecnologías modernas.

Fuente.

Código binario (binary) – una secuencia de ceros y unidades. Es una forma universal de mostrar cualquier información (mensajes de texto, imágenes, materiales de sonido y vídeo). La información codificada en código binario es muy conveniente para almacenar, procesar y transferir de un dispositivo electrónico a otro, lo que constituye la ventaja de utilizar la información de codificación binaria.

La codificación binaria de la información se utiliza para diferentes datos:

- La codificación binaria de la información de texto consiste en asignar designaciones alfabéticas, numéricas y de otro tipo a un código específico. Se escribe en la memoria de la computadora por una cadena de ceros y unidades. El procedimiento para codificar el alfabeto en código binario utilizando la norma ASCII es un buen ejemplo;

- el tipo de gráficos utilizados afecta a la forma en que la información gráfica está codificada en forma binaria;

- La codificación binaria de la información sonora se produce después de que se muestre la onda sonora y se asigne la correspondiente cadena binaria de números a cada componente;

- La codificación binaria de las imágenes de vídeo combina los principios de trabajo con el sonido y las imágenes de mapa de bits.

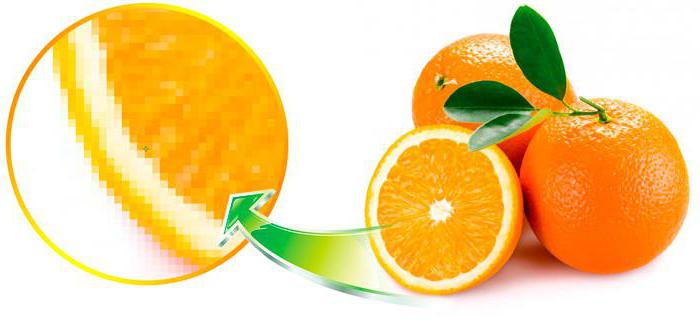

Procesamiento de imágenes gráficas

La codificación de la información textual, sonora y gráfica se lleva a cabo con el fin de su intercambio cualitativo, edición y almacenamiento. La codificación de los mensajes de información de diversos tipos tiene sus propias características distintivas, pero, en general, se reduce a convertirlos en forma binaria.

Fuente.

Dibujos, ilustraciones en libros, esquemas, dibujos, etc. – ejemplos de mensajes gráficos. La gente moderna utiliza cada vez más la tecnología informática para trabajar con datos gráficos.

Fuente.

La esencia de la codificación de la información gráfica y sonora es convertirla de analógica a digital.

La codificación de la información gráfica es un procedimiento de asignación de un determinado valor de código a cada componente de la imagen.

Los métodos de codificación de la información gráfica se someten a métodos de representación de imágenes (raster o vector):

- El principio de la codificación de la información gráfica en forma de mapa de bits es asignar una codificación binaria a los píxeles (puntos) que forman la imagen. El código contiene información sobre los tonos de color de cada punto. Un ejemplo son las imágenes tomadas con una cámara digital.

Fuente.

- La codificación vectorial se realiza mediante funciones matemáticas. A los componentes de las imágenes vectoriales (puntos, líneas y otras formas geométricas) se les asigna una secuencia binaria que define varios parámetros. Estos gráficos se utilizan a menudo en una imprenta.

Fuente.

Mucha gente se preguntará: “¿Cuál es la esencia de la codificación de la información gráfica presentada en forma de imágenes 3D”? El asunto es que el trabajo con los datos 3D combina formas de codificación raster y vectorial.

La codificación y el procesamiento de la información gráfica de diferentes formatos tiene sus ventajas y también sus desventajas.

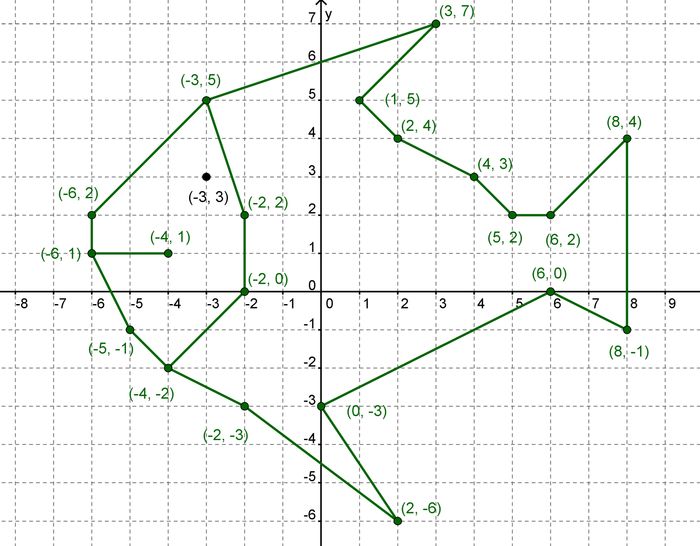

Método de coordenadas

Cualquier dato puede ser transmitido usando números binarios, incluyendo imágenes gráficas que representan un conjunto de puntos. El método de las coordenadas se utiliza para hacer coincidir números y puntos en código binario.

El método de las coordenadas en el plano se basa en el estudio de las propiedades de un punto en el sistema de coordenadas con el eje horizontal Buey y el eje vertical Oy. El punto tendrá 2 coordenadas.

Fuente.

Si 3 ejes mutuamente perpendiculares X, Y y Z pasan por el origen de las coordenadas, se utiliza el método de las coordenadas en el espacio. La posición del punto en este caso está determinada por tres coordenadas.

Sistema de coordenadas en el espacio

Conversión de números en código binario

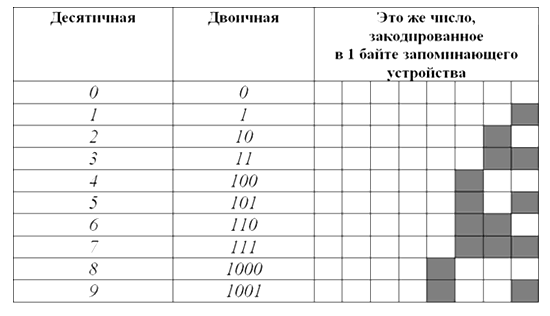

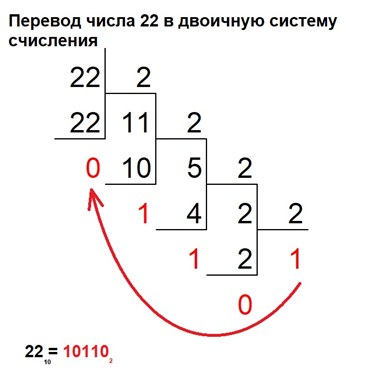

La forma numérica de codificar la información, es decir, la transición de los datos de información a una secuencia binaria de números, está muy extendida en la tecnología informática moderna. Cualquier información numérica, simbólica, gráfica, de audio y video puede ser codificada con números binarios. Consideremos con más detalle la codificación de la información numérica.

El sistema numérico acostumbrado por los humanos (basado en números del 0 al 9), que utilizamos activamente, apareció hace varios cientos de miles de años. El trabajo de todo el equipo de computación está organizado en un sistema numérico binario. Su alfabeto es mínimo, 0 y 1. La codificación de los números se realiza pasando del sistema numérico decimal al binario y realizando los cálculos directamente con los números binarios.

Fuente.

La codificación y el procesamiento de la información numérica se debe al resultado deseado de trabajar con números. Así, si se introduce un número dentro de un archivo de texto, tendrá el código de un símbolo tomado de la norma utilizada. Para los cálculos matemáticos, los datos numéricos se convierten de una manera completamente diferente.

Fuente.

Los principios de codificación de la información numérica presentada como números enteros o fraccionarios (positivos, negativos o iguales a 0) son de naturaleza diferente. La forma más sencilla de traducir un entero decimal a un sistema numérico binario es la siguiente:

- el número debe ser dividido por 2;

- si el privado es mayor que 1, la división debe continuar hasta que el resultado sea 0 o 1;

- anotar el resultado de la última operación y los residuos de fisión en orden inverso;

- el número obtenido y será el valor del código deseado.

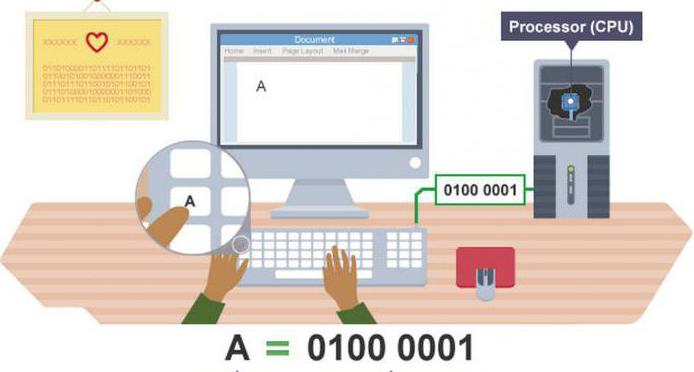

Una de las partes más importantes del trabajo informático es la codificación de la información de los caracteres. Toda la variedad de números, letras rusas y latinas, signos de puntuación, símbolos matemáticos y símbolos especiales separados se refieren a los símbolos. El método simbólico de codificación consiste en asignar un determinado carácter con un código de conjunto.

Fuente.

Fuente.

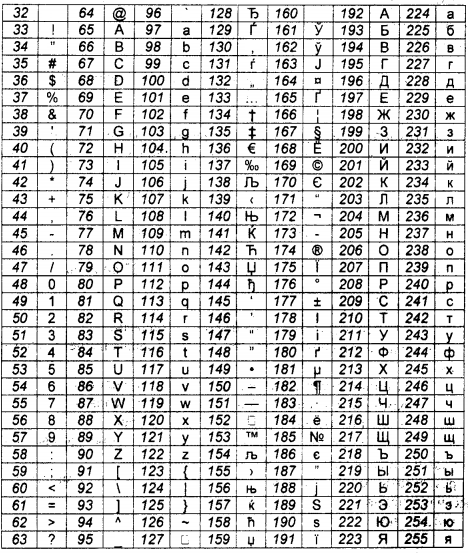

Consideremos con más detalle las normas más extendidas – ASCII y Unicode – que se aplican a la codificación de la información de los símbolos en todo el mundo.

Fuente. Fragmento de la tabla ASCII

Inicialmente se determinó que para cualquier carácter, se asignan 8 bits (1 bit es “0” o “1”) de la secuencia binaria a la memoria de la computadora. La primera tabla de codificación ASCII (traducida como “American messaging code standard”) contenía 256 caracteres. El número limitado de caracteres codificados, que impedía el intercambio internacional de datos, hizo que se necesitara una norma Unicode basada en el ASCII. Este sistema de codificación internacional contiene 65536 caracteres. Un gran número de todo tipo de caracteres han sido codificados usando una codificación de caracteres de 16 bits.

La codificación de la información simbólica y numérica es fundamentalmente diferente. Para introducir o emitir números al monitor o para usarlos en un archivo de texto, se convierten de acuerdo con el sistema de codificación. En el proceso de las operaciones aritméticas el número tiene un valor binario completamente diferente, porque va al sistema numérico binario, donde se realizan todas las acciones computacionales.

Elija el método de codificación de la información: gráfico, numérico o simbólico, basado en el propósito de la codificación. Por ejemplo, el número “21” puede introducirse en la memoria de la computadora con números o letras “veintiuno”, la palabra “Invierno” puede transmitirse con las letras rusas “invierno” o latinas “ZIMA”, el código de barras del producto se transmite por imagen y números.

Transformación del sonido

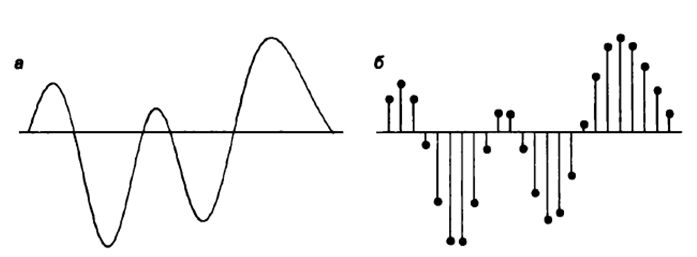

Las tecnologías informáticas se están aplicando con éxito en diversos campos, entre ellos la codificación y el procesamiento de la información sonora. Desde un punto de vista físico, el sonido es una señal sólida analógica. El proceso de convertirlo en una serie de pulsos eléctricos se llama codificación de información de sonido.

Tareas a resolver para una exitosa digitalización de la señal:

- discretamente (dividir los datos de audio en secciones elementales midiendo las fluctuaciones del aire a intervalos iguales);

- digitalizar (asignar un código numérico a cada elemento).

Fuente. Conversión de audio: a) señal analógica; b) señal binaria.

Se puede distinguir entre los siguientes métodos de codificación de la información de audio:

- Método FM. Su esencia se reduce a la división del sonido por medio de convertidores analógico-digitales (ADC) en los mismos elementos simples, que son codificados además por el código binario. La imperfección del método de FM se manifiesta en la baja calidad de la grabación de sonido debido a la pérdida de algo de volumen del mensaje de sonido original.

- El método de la tabla de ondas (onda tabular) permite obtener un producto de alta calidad, porque las tablas de muestras desarrolladas (muestras de sonidos “en vivo”) permiten expresar los números binarios de diversos parámetros de la señal entrante.

Fuente.

Procesamiento de texto

El texto es un orden significativo de signos. Gracias a la utilización de una computadora, la codificación y el procesamiento de la información de texto (mecanografía, edición, intercambio y almacenamiento de texto escrito) se ha hecho mucho más fácil.

Codificación de información de texto – asignando cualquier carácter de código de texto del sistema de codificación. Se distinguen las siguientes normas de codificación:

- El ASCII es el primer sistema de codificación internacional que contiene códigos de 256 caracteres.

- El Unicode es un estándar ASCII extendido que tiene 256 veces el tamaño del estándar.

- KOI-8, SR1251, SR866, ISO – tablas de codificación de caracteres rusos. Debe entenderse que un documento codificado por una norma no se leerá en otra.

Los siguientes conceptos se encuentran a menudo en las tareas de codificación de información de texto:

- el poder del alfabeto;

- unidades de memoria (bits y bytes).

Por ejemplo, la potencia del alfabeto ASCII es de 256 caracteres. En este caso, un carácter ocupa 8 bits (o 1 byte) de memoria, mientras que Unicode – 35536 caracteres y 16 bits (o 2 bytes), respectivamente.